对于独立站卖家而言,A/B测试是优化页面、提升转化率的利器。然而,许多卖家在欣喜地看到“测试结果显著”后,全站推广新方案却效果不佳,甚至导致转化率下降。这背后,往往是踩中了A/B测试的统计学陷阱。仅凭工具给出的“获胜”提示就做决策,是极其危险的。

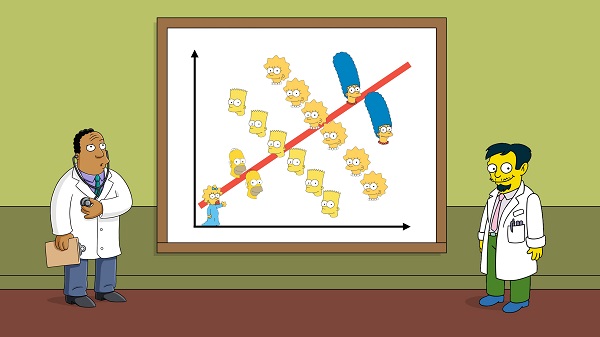

陷阱一:辛普森悖论——被聚合数据掩盖的真相

辛普森悖论是数据分析中一个经典陷阱。当您将不同来源或群体的数据合并时,可能会得出与分组数据完全相反的结论。

场景模拟: 您测试一个新版产品详情页。总体数据可能显示新版转化率(如3.5%)略高于旧版(3.4%)。但若按流量来源拆分,可能会发现:来自谷歌广告的用户,旧版转化率更高;来自社交媒体的用户,新版转化率更高。 如果测试期间社交媒体流量占比突然增大,就会在总体上“拉高”新版的平均表现,掩盖了它对核心付费流量效果不佳的事实。

规避策略: 在进行结果分析时,务必进行多维细分。除了看总体数据,还要分别检查不同流量来源、用户设备(PC/移动端)、新老访客等关键维度的表现。

陷阱二:伪相关与因果错觉

A/B测试的核心是建立因果关系:是“版本B”这个因,导致了“转化率提升”这个果。但人们常常将“相关”误认为“因果”。

场景模拟: 您在圣诞季期间同时进行了两个测试:一个测试页面标题,另一个测试结账按钮颜色。测试结束后,红色按钮版本“显著获胜”。但真实原因可能是,圣诞季本身带来的购物热情使得任何醒目的号召性用语(CTA)都更有效,而非红色本身。您错误地将季节性增长归因于按钮颜色。

规避策略: 确保测试变量单一且纯粹。控制测试周期,避免在重大促销或节假日期间进行关键测试,以减少外部变量的干扰。

陷阱三:样本量不足与过早结束测试

这是最常见也最致命的陷阱。测试刚开始不久,看到某个版本数据“暂时领先”,就迫不及待地宣布其为赢家并结束测试。

统计学原理: 任何测试初期数据都存在巨大的随机波动。样本量不足时,计算出的“显著性”是不可靠的,犯“假阳性”错误(即认为有差异但实际上没有)的概率极高。

规避策略:

事前计算样本量: 在测试前,使用A/B测试样本量计算器,根据您当前的基线转化率、期望检测的最小提升幅度(MDE)和统计功效(通常设为80%),计算出需要的最低样本量。

固定测试时长: 必须跑满预先计算的样本量或达到预设的测试周期(如至少1-2个完整的业务周期),不要凭感觉中途停止。

陷阱四:多重检验与“P值操控”

如果您在同一个测试中不停地查看结果、反复进行显著性检验(“窥探”),或者同时对页面的多个元素(标题、图片、按钮)进行A/B/C/D...测试,那么您“偶然”得到一个显著结果的概率会大大增加。

规避策略:

预先设定一次检验: 确定好样本量,在收集完所有数据后只进行一次显著性检验。

使用校正方法: 如果必须进行多重比较,应使用邦费罗尼校正等统计方法来调整显著性水平。

采用多变量测试: 若要测试多个元素,应使用专门的多变量测试工具,它能更好地处理元素间的交互作用。

总结:构建稳健的A/B测试文化

规避这些陷阱,要求独立站运营者从“凭直觉看数据”转向“用统计学思维做决策”。请牢记:A/B测试不是一场赌博,而是一门科学。通过预先规划、确保样本量、细分分析、审慎归因,您才能拨开数据的迷雾,让每一次测试都为您的独立站增长提供真实、可靠的动力。